AI Agent在视频编辑中的应用:自动剪辑与特效添加

关键词:AI Agent、视频编辑、自动剪辑、特效生成、计算机视觉、深度学习、视频处理

摘要:本文深入探讨了AI Agent在视频编辑领域的创新应用,重点分析了自动剪辑和特效添加的技术原理与实现方法。我们将从计算机视觉和深度学习的基础理论出发,详细讲解视频内容理解、镜头分割、场景识别等核心技术,并通过Python代码示例展示如何构建一个基础的AI视频编辑系统。文章还将介绍当前最先进的视频处理算法,分析实际应用场景,并提供完整的工具链和资源推荐。最后,我们将展望AI视频编辑的未来发展趋势和技术挑战。

1. 背景介绍

1.1 目的和范围

随着短视频平台的爆发式增长和视频内容的普及,传统的手工视频编辑方式已经无法满足海量内容生产的需求。AI Agent在视频编辑中的应用旨在解决以下核心问题:

降低视频制作门槛,使非专业用户也能产出高质量内容大幅提升视频制作效率,实现批量自动化处理通过智能算法增强创意表达,提供传统手段难以实现的特效

本文的范围涵盖从基础理论到实际应用的完整技术栈,包括视频分析、内容理解、自动剪辑决策和特效生成等关键技术。

1.2 预期读者

本文适合以下读者群体:

计算机视觉和多媒体处理领域的研究人员视频编辑软件开发工程师数字媒体内容创作者对AI创意工具感兴趣的产品经理计算机科学相关专业的学生

1.3 文档结构概述

本文采用从理论到实践的结构组织内容:

首先介绍核心概念和技术背景然后深入讲解算法原理和数学模型接着通过实际代码示例展示实现细节最后探讨应用场景和未来发展方向

1.4 术语表

1.4.1 核心术语定义

AI Agent:具备一定自主决策能力的智能程序,能够感知环境、分析信息并执行特定任务镜头分割(Shot Detection):将视频流分割为不同镜头的技术场景识别(Scene Recognition):理解视频中场景内容的技术转场检测(Transition Detection):识别镜头之间过渡效果的技术视频摘要(Video Summarization):自动生成视频精华片段的技术

1.4.2 相关概念解释

光流(Optical Flow):描述视频帧之间像素运动的技术时序动作定位(Temporal Action Localization):识别视频中特定动作发生时间的技术风格迁移(Style Transfer):将艺术风格应用到视频的技术神经渲染(Neural Rendering):使用神经网络生成或修改视频内容的技术

1.4.3 缩略词列表

CV:计算机视觉(Computer Vision)CNN:卷积神经网络(Convolutional Neural Network)RNN:循环神经网络(Recurrent Neural Network)LSTM:长短期记忆网络(Long Short-Term Memory)GAN:生成对抗网络(Generative Adversarial Network)NLP:自然语言处理(Natural Language Processing)

2. 核心概念与联系

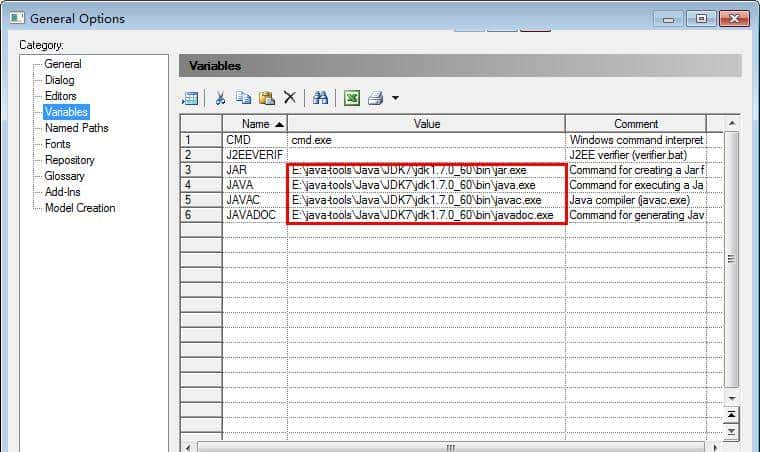

AI Agent在视频编辑中的工作流程可以表示为以下架构图:

视频编辑AI Agent的核心组件包括:

视频分析模块:负责理解视频内容,提取关键特征决策引擎:基于分析结果制定剪辑策略渲染引擎:执行实际的视频修改和特效添加

这些组件之间的关系如下图所示:

3. 核心算法原理 & 具体操作步骤

3.1 视频内容分析算法

视频内容分析是自动剪辑的基础,主要包括以下步骤:

关键帧提取:使用自适应阈值法选择信息量最大的帧镜头边界检测:基于颜色直方图和运动特征的变化检测场景分类:使用预训练的CNN模型识别场景类型

以下是使用OpenCV实现镜头分割的Python代码示例:

import cv2

import numpy as np

def detect_shots(video_path, threshold=0.5):

cap = cv2.VideoCapture(video_path)

ret, prev_frame = cap.read()

prev_hist = cv2.calcHist([cv2.cvtColor(prev_frame, cv2.COLOR_BGR2HSV)],

[0,1,2], None, [8,8,8], [0,256,0,256,0,256])

cv2.normalize(prev_hist, prev_hist)

shot_boundaries = [0]

frame_count = 1

while cap.isOpened():

ret, curr_frame = cap.read()

if not ret:

break

curr_hist = cv2.calcHist([cv2.cvtColor(curr_frame, cv2.COLOR_BGR2HSV)],

[0,1,2], None, [8,8,8], [0,256,0,256,0,256])

cv2.normalize(curr_hist, curr_hist)

# 计算直方图差异

diff = cv2.compareHist(prev_hist, curr_hist, cv2.HISTCMP_CORREL)

if diff < threshold:

shot_boundaries.append(frame_count)

prev_hist = curr_hist.copy()

frame_count += 1

cap.release()

return shot_boundaries

3.2 自动剪辑决策算法

剪辑决策需要考虑多种因素:

内容重要性:基于人脸检测、动作幅度等情感曲线:构建视频的情感波动曲线节奏匹配:根据背景音乐的节奏决定剪辑点

from moviepy.editor import VideoFileClip, concatenate_videoclips

import numpy as np

def auto_edit(video_path, shot_boundaries, target_duration):

clips = []

cap = cv2.VideoCapture(video_path)

fps = cap.get(cv2.CAP_PROP_FPS)

cap.release()

# 计算每个镜头的持续时间

durations = [shot_boundaries[i+1]-shot_boundaries[i]

for i in range(len(shot_boundaries)-1)]

# 根据重要性选择镜头 (简化版)

selected_shots = []

remaining_time = target_duration * fps

for i, duration in enumerate(durations):

if duration <= remaining_time:

selected_shots.append(i)

remaining_time -= duration

# 拼接选中的镜头

video_clip = VideoFileClip(video_path)

subclips = []

for i in selected_shots:

start = shot_boundaries[i] / fps

end = shot_boundaries[i+1] / fps

subclips.append(video_clip.subclip(start, end))

final_clip = concatenate_videoclips(subclips)

return final_clip

3.3 智能特效添加算法

特效添加需要考虑内容上下文和美学原则:

import torch

from torchvision import transforms

from PIL import Image, ImageFilter

def apply_smart_effects(frame, scene_type):

"""

根据场景类型添加特效

:param frame: 输入帧(PIL Image)

:param scene_type: 场景类别

:return: 处理后的帧

"""

if scene_type == "landscape":

# 增强色彩和对比度

frame = transforms.ColorJitter(

brightness=0.2, contrast=0.2, saturation=0.3)(frame)

# 添加轻微晕影效果

width, height = frame.size

mask = Image.new("L", (width, height), 0)

for y in range(height):

for x in range(width):

dist = ((x - width/2)**2 + (y - height/2)**2)**0.5

max_dist = ((width/2)**2 + (height/2)**2)**0.5

val = int(255 * (1 - 0.6 * dist/max_dist))

mask.putpixel((x, y), val)

frame.putalpha(mask)

elif scene_type == "interview":

# 人脸区域增强

frame = transforms.functional.adjust_sharpness(frame, 1.5)

# 背景模糊

frame = frame.filter(ImageFilter.GaussianBlur(radius=2))

return frame

4. 数学模型和公式 & 详细讲解 & 举例说明

4.1 镜头分割的数学模型

镜头边界检测可以建模为时间序列突变点检测问题。给定视频帧序列

F

1

,

F

2

,

.

.

.

,

F

n

F_1, F_2, …, F_n

F1,F2,…,Fn,我们计算相邻帧的差异:

其中

D

D

D 是差异度量函数,常用方法包括:

颜色直方图差异:

像素差异:

运动向量差异:

4.2 剪辑决策的优化模型

自动剪辑可以建模为带约束的优化问题:

其中:

x

i

x_i

xi 是二元决策变量,表示是否选择第

i

i

i 个镜头

s

i

s_i

si 是第

i

i

i 个镜头的重要性分数

d

i

d_i

di 是第

i

i

i 个镜头的持续时间

T

T

T 是目标视频总时长

重要性分数

s

i

s_i

si 可以综合多种因素计算:

其中:

f

i

f_i

fi 是人脸相关特征(如大小、数量)

a

i

a_i

ai 是动作强度

e

i

e_i

ei 是情感强度

α

,

β

,

γ

alpha, eta, gamma

α,β,γ 是权重参数

4.3 特效生成的概率模型

许多视频特效可以基于生成模型实现,如变分自编码器(VAE):

其中:

x

x

x 是输入视频帧

z

z

z 是潜在表示

q

ϕ

q_phi

qϕ 是编码器

p

θ

p_ heta

pθ 是解码器

D

K

L

D_{KL}

DKL 是KL散度

对于风格迁移,可以使用Gram矩阵匹配:

其中

G

ϕ

l

G^l_phi

Gϕl 是第

l

l

l 层特征的Gram矩阵,

F

F

F 是内容图像,

S

S

S 是风格图像。

5. 项目实战:代码实际案例和详细解释说明

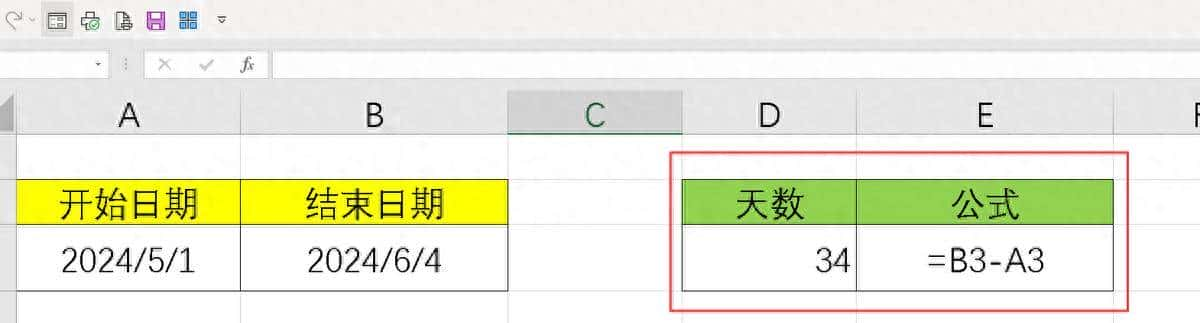

5.1 开发环境搭建

推荐使用以下环境配置:

# 创建conda环境

conda create -n video_ai python=3.8

conda activate video_ai

# 安装核心库

pip install opencv-python torch torchvision moviepy scikit-image

pip install 'git+https://github.com/facebookresearch/pytorch3d.git'

# 可选:安装GPU支持

conda install cudatoolkit=11.3 -c pytorch

5.2 源代码详细实现和代码解读

下面是一个完整的AI视频编辑系统示例:

import cv2

import numpy as np

from moviepy.editor import VideoFileClip, concatenate_videoclips, ImageSequenceClip

from PIL import Image

import torch

from torchvision import models, transforms

class VideoAIEditor:

def __init__(self, model_path="resnet18.pth"):

# 初始化模型

self.device = torch.device("cuda" if torch.cuda.is_available() else "cpu")

self.model = self._init_scene_model(model_path)

self.transform = transforms.Compose([

transforms.Resize(256),

transforms.CenterCrop(224),

transforms.ToTensor(),

transforms.Normalize(mean=[0.485, 0.456, 0.406],

std=[0.229, 0.224, 0.225]),

])

def _init_scene_model(self, path):

model = models.resnet18(pretrained=False)

num_ftrs = model.fc.in_features

model.fc = torch.nn.Linear(num_ftrs, 5) # 假设有5种场景

model.load_state_dict(torch.load(path, map_location=self.device))

model = model.to(self.device)

model.eval()

return model

def analyze_video(self, video_path):

"""分析视频内容,返回镜头边界和场景信息"""

cap = cv2.VideoCapture(video_path)

fps = cap.get(cv2.CAP_PROP_FPS)

# 镜头检测

shot_boundaries = self._detect_shots(cap)

# 场景分类

scene_info = []

for i in range(len(shot_boundaries)-1):

# 取每个镜头的中间帧进行分类

middle_frame_pos = (shot_boundaries[i] + shot_boundaries[i+1]) // 2

cap.set(cv2.CAP_PROP_POS_FRAMES, middle_frame_pos)

ret, frame = cap.read()

if ret:

scene_type = self._classify_scene(frame)

duration = (shot_boundaries[i+1] - shot_boundaries[i]) / fps

scene_info.append({

"start": shot_boundaries[i]/fps,

"end": shot_boundaries[i+1]/fps,

"duration": duration,

"type": scene_type

})

cap.release()

return scene_info

def _detect_shots(self, cap, threshold=0.3):

"""检测镜头边界"""

shot_boundaries = [0]

ret, prev_frame = cap.read()

prev_hist = self._calc_hist(prev_frame)

frame_count = 1

while cap.isOpened():

ret, curr_frame = cap.read()

if not ret:

break

curr_hist = self._calc_hist(curr_frame)

diff = cv2.compareHist(prev_hist, curr_hist, cv2.HISTCMP_CORREL)

if diff < threshold:

shot_boundaries.append(frame_count)

prev_hist = curr_hist

frame_count += 1

return shot_boundaries

def _calc_hist(self, frame):

"""计算HSV颜色直方图"""

hsv = cv2.cvtColor(frame, cv2.COLOR_BGR2HSV)

hist = cv2.calcHist([hsv], [0,1,2], None, [8,8,8], [0,256,0,256,0,256])

cv2.normalize(hist, hist)

return hist

def _classify_scene(self, frame):

"""分类场景类型"""

pil_img = Image.fromarray(cv2.cvtColor(frame, cv2.COLOR_BGR2RGB))

img_tensor = self.transform(pil_img).unsqueeze(0).to(self.device)

with torch.no_grad():

outputs = self.model(img_tensor)

_, pred = torch.max(outputs, 1)

scene_types = ["interview", "landscape", "action", "indoor", "other"]

return scene_types[pred.item()]

def auto_edit(self, video_path, target_duration, output_path):

"""执行自动编辑"""

scene_info = self.analyze_video(video_path)

# 简单剪辑策略:选择最重要的镜头直到达到目标时长

selected_scenes = []

total_duration = 0

for scene in sorted(scene_info, key=lambda x: x["duration"], reverse=True):

if total_duration + scene["duration"] <= target_duration:

selected_scenes.append(scene)

total_duration += scene["duration"]

# 应用特效并生成最终视频

self._apply_effects_and_render(video_path, selected_scenes, output_path)

def _apply_effects_and_render(self, video_path, scenes, output_path):

"""应用特效并渲染最终视频"""

video_clip = VideoFileClip(video_path)

processed_clips = []

for scene in scenes:

# 提取原始片段

clip = video_clip.subclip(scene["start"], scene["end"])

# 应用特效

if scene["type"] == "interview":

# 增强人脸区域

frames = [self._enhance_face(np.array(f)) for f in clip.iter_frames()]

elif scene["type"] == "landscape":

# 增强色彩

frames = [self._enhance_landscape(np.array(f)) for f in clip.iter_frames()]

else:

frames = [np.array(f) for f in clip.iter_frames()]

# 创建处理后的片段

processed_clip = ImageSequenceClip(frames, fps=clip.fps)

processed_clips.append(processed_clip)

# 拼接所有片段

final_clip = concatenate_videoclips(processed_clips)

final_clip.write_videofile(output_path, codec="libx264")

def _enhance_face(self, frame):

"""增强人脸特效"""

# 使用OpenCV的人脸检测

face_cascade = cv2.CascadeClassifier(cv2.data.haarcascades + 'haarcascade_frontalface_default.xml')

gray = cv2.cvtColor(frame, cv2.COLOR_BGR2GRAY)

faces = face_cascade.detectMultiScale(gray, 1.1, 4)

# 创建模糊背景

blurred = cv2.GaussianBlur(frame, (25, 25), 0)

# 恢复人脸区域

for (x, y, w, h) in faces:

blurred[y:y+h, x:x+w] = frame[y:y+h, x:x+w]

# 增强人脸对比度

face_roi = blurred[y:y+h, x:x+w]

lab = cv2.cvtColor(face_roi, cv2.COLOR_BGR2LAB)

l, a, b = cv2.split(lab)

clahe = cv2.createCLAHE(clipLimit=2.0, tileGridSize=(8,8))

l = clahe.apply(l)

lab = cv2.merge((l, a, b))

face_roi = cv2.cvtColor(lab, cv2.COLOR_LAB2BGR)

blurred[y:y+h, x:x+w] = face_roi

return blurred

def _enhance_landscape(self, frame):

"""增强风景特效"""

# 增加对比度和饱和度

hsv = cv2.cvtColor(frame, cv2.COLOR_BGR2HSV)

h, s, v = cv2.split(hsv)

s = cv2.multiply(s, 1.2)

v = cv2.multiply(v, 1.1)

hsv = cv2.merge((h, s, v))

frame = cv2.cvtColor(hsv, cv2.COLOR_HSV2BGR)

# 添加轻微晕影效果

rows, cols = frame.shape[:2]

kernel_x = cv2.getGaussianKernel(cols, cols/3)

kernel_y = cv2.getGaussianKernel(rows, rows/3)

kernel = kernel_y * kernel_x.T

mask = 255 * kernel / np.linalg.norm(kernel)

mask = cv2.resize(mask, (cols, rows))[:,:,np.newaxis]

frame = cv2.addWeighted(frame, 0.7,

cv2.merge([mask]*3), 0.3, 0)

return frame

5.3 代码解读与分析

这个AI视频编辑系统实现了以下核心功能:

视频分析模块:

使用颜色直方图差异检测镜头边界基于预训练的ResNet模型进行场景分类提取每个镜头的元数据(时长、类型等)

剪辑决策模块:

简单的基于时长优先的镜头选择策略可根据需要扩展更复杂的决策逻辑

特效渲染模块:

针对不同场景类型应用特定特效人脸场景:背景模糊+人脸增强风景场景:色彩增强+晕影效果

关键实现细节:

使用OpenCV处理视频帧的低级操作利用PyTorch进行深度学习推理通过MoviePy实现高级视频编辑操作采用模块化设计,便于扩展新功能

6. 实际应用场景

AI Agent在视频编辑中的应用已经渗透到多个领域:

社交媒体内容创作:

自动生成短视频精华片段批量处理用户生成内容(UGC)根据平台算法优化视频结构

专业影视制作:

粗剪自动化,减少人工工作量智能素材管理,自动标记和分类特效预生成,加速后期制作流程

教育培训:

自动生成教学视频重点摘要智能添加教学辅助图形和标注多语言字幕自动生成和同步

安防监控:

自动提取关键事件片段异常行为检测和标记多摄像头内容智能合成

电子商务:

产品视频自动生成个性化视频广告制作AR特效实时预览

7. 工具和资源推荐

7.1 学习资源推荐

7.1.1 书籍推荐

《Computer Vision: Algorithms and Applications》- Richard Szeliski《Deep Learning for Computer Vision》- Rajalingappaa Shanmugamani《Video Processing and Computational Video》- Daniel Cremers

7.1.2 在线课程

Coursera: “Deep Learning for Computer Vision” – University of MichiganUdacity: “AI for Video Editing” NanodegreeFast.ai: “Practical Deep Learning for Coders” Part 2

7.1.3 技术博客和网站

Google AI Blog – 视频理解相关研究Facebook Research – 视频生成技术Towards Data Science – 计算机视觉专栏

7.2 开发工具框架推荐

7.2.1 IDE和编辑器

VS Code + Python扩展PyCharm Professional (支持视频调试)Jupyter Notebook (原型开发)

7.2.2 调试和性能分析工具

PyTorch ProfilerOpenCV的CUDA加速工具NVIDIA Nsight (GPU分析)

7.2.3 相关框架和库

OpenCV – 基础视频处理PyTorch/TensorFlow – 深度学习MoviePy – 高级视频编辑FFmpeg – 底层视频处理Detectron2 – 对象检测

7.3 相关论文著作推荐

7.3.1 经典论文

“Two-Stream Convolutional Networks for Action Recognition” – Simonyan & Zisserman“SlowFast Networks for Video Recognition” – Facebook AI Research“GANs for Video Generation” – OpenAI

7.3.2 最新研究成果

“Neural Video Editing” – Google Research 2023“Diffusion Models for Video Synthesis” – 2023“Large Language Models for Video Editing Commands” – Meta 2023

7.3.3 应用案例分析

Adobe Premiere Pro中的AI功能技术解析TikTok自动剪辑系统架构YouTube短视频自动生成技术

8. 总结:未来发展趋势与挑战

发展趋势

多模态融合:结合音频、文本和视频的深度理解实时编辑:低延迟的云端AI视频处理个性化生成:基于用户偏好的自适应编辑风格交互式AI:自然语言指令驱动的视频编辑3D视频处理:面向VR/AR的内容生成

技术挑战

计算资源需求:高分辨率视频处理的计算成本创意与控制的平衡:保持AI创意同时提供精确控制数据偏见问题:训练数据导致的风格偏好偏差版权与伦理:AI生成内容的版权归属评估标准:缺乏客观的视频质量评价指标

9. 附录:常见问题与解答

Q1:AI自动剪辑会取代人类编辑吗?

A:AI不会完全取代人类编辑,而是成为强大的辅助工具。AI擅长处理重复性任务和基础编辑,而人类编辑在创意决策和艺术表达上仍不可替代。未来的趋势是人机协作,AI处理技术性工作,人类专注于创意部分。

Q2:当前AI视频编辑的主要限制是什么?

A:主要限制包括:1) 对抽象创意概念的理解有限;2) 处理非常规视频内容时表现不稳定;3) 需要大量计算资源进行高质量渲染;4) 对上下文和文化的理解不够深入。

Q3:如何评估一个AI视频编辑系统的质量?

A:可以从以下几个维度评估:

技术指标:处理速度、内存占用等内容保留度:重要内容是否被恰当保留美学质量:符合人类审美标准的程度多样性:处理不同类型视频的能力用户满意度:目标用户的实际使用反馈

Q4:训练一个视频编辑AI需要什么样的数据?

A:需要多类型的数据集:

原始视频素材(各种类型和风格)专业编辑后的对应版本编辑决策的元数据(剪辑点选择原因等)用户反馈数据(喜欢/不喜欢的编辑结果)视频质量评分数据

Q5:如何解决AI视频编辑中的版权问题?

A:建议采取以下措施:

使用明确授权的训练数据实现内容溯源机制添加水印标识AI生成内容建立使用第三方素材的授权检查流程提供版权声明生成功能

10. 扩展阅读 & 参考资料

Google Research: Video UnderstandingFacebook AI: Video SynthesisOpenCV官方文档PyTorch视频处理教程ACM Multimedia会议论文集

通过本文的全面探讨,我们看到了AI Agent在视频编辑领域的巨大潜力和广阔前景。随着技术的不断进步,AI将成为视频创作过程中不可或缺的智能伙伴,为内容创作者提供前所未有的强大工具。然而,要实现真正智能、创意无限的视频编辑AI,我们还需要在算法创新、计算架构和人机交互等多个方面持续突破。

相关文章